Rejeter la notice

Ateliers Live Resolve - Formez-vous en ligne tous les mois avec Forest !

Faites rapidement évoluer la qualité de vos étalonnage avec nos ateliers mensuels de 3h.

Toutes les infos

Toutes les infos

Ateliers et Formations

-

Accroche marketing: Préparez-vous pour vos premiers tournages en caméras RED et maîtrisez le workflow de tournage RAW !Repaire publié le 23 Jul 2019

-

Accroche marketing: Participez à un réel tournage de fiction et développez votre vision artistique avec cette formation en résidence immersiveRepaire publié le 20 Feb 2025

-

Accroche marketing: Ajoutez une identité, une intention, de la créativité à vos images avec notre formation exceptionnelle de 3 joursRepaire publié le 24 Oct 2024

Les fascinants travaux de Ren Ng

Discussion dans 'Effets spéciaux visuels' créé par Sequelles, 25 Janvier 2006.

Tags:

Page 1 sur 2

-

-

Publié parLucas.janiszewski 19 Décembre 2025

Publié parLucas.janiszewski 19 Décembre 2025 -

Publié parLucas.janiszewski 18 Décembre 2025

Publié parLucas.janiszewski 18 Décembre 2025 -

Publié parLucas.janiszewski 18 Décembre 2025

Publié parLucas.janiszewski 18 Décembre 2025 -

Publié parLucas.janiszewski 2 Décembre 2025

Publié parLucas.janiszewski 2 Décembre 2025 -

Publié parLucas.janiszewski 18 Novembre 2025

Publié parLucas.janiszewski 18 Novembre 2025

-

-

-

Publié parmaximetrage 19 Septembre 2025

Publié parmaximetrage 19 Septembre 2025 -

Publié parClmR 18 Juillet 2025

Publié parClmR 18 Juillet 2025 -

Publié parValentin Hautot 18 Juillet 2025

Publié parValentin Hautot 18 Juillet 2025 -

Publié parGRG 11 Juillet 2025

Publié parGRG 11 Juillet 2025 -

Publié parFranz Olm 29 Janvier 2025

Publié parFranz Olm 29 Janvier 2025

-

-

-

-

Publié parMarina 29 Octobre 2025

Publié parMarina 29 Octobre 2025 -

Publié parmaximetrage 19 Septembre 2025

Publié parmaximetrage 19 Septembre 2025 -

Publié parMarina 30 Avril 2025

Publié parMarina 30 Avril 2025 -

Publié parMarina 30 Octobre 2024

Publié parMarina 30 Octobre 2024 -

Publié parMarina 3 Juillet 2024

Publié parMarina 3 Juillet 2024

-

-

-

Conseil achat camescope, pour filmer match de foot enfant

BarruWhite 7 Décembre 2025

-

Le P, A, S ou M en vidéo & retour sur le Nikon ZR

Lolive67 17 Décembre 2025

-

Correction super8 numérisé

RVQ35 4 Décembre 2025

-

Neat ou Topaz

BLONDINUS 24 Décembre 2025

-

Upgrade config ... DVR

JB60 30 Décembre 2025, à 17:04

Chargement... -

Conseil achat camescope, pour filmer match de foot enfant

-

Chargement...

-

Chargement...

-

-

DaVinci - Echec Synchro Auto

Eraipre 2 Janvier 2026, à 00:16

-

Upgrade config ... DVR

JB60 30 Décembre 2025, à 17:04

-

Lenteur première pro

Jean-Pierre Léman 29 Décembre 2025, à 20:14

-

keyframes sur effets

allfa 29 Décembre 2025, à 10:04

-

Quand même ...

sapiens 28 Décembre 2025, à 16:45

Chargement... -

DaVinci - Echec Synchro Auto

Dernières occasions

Dernières formations

-

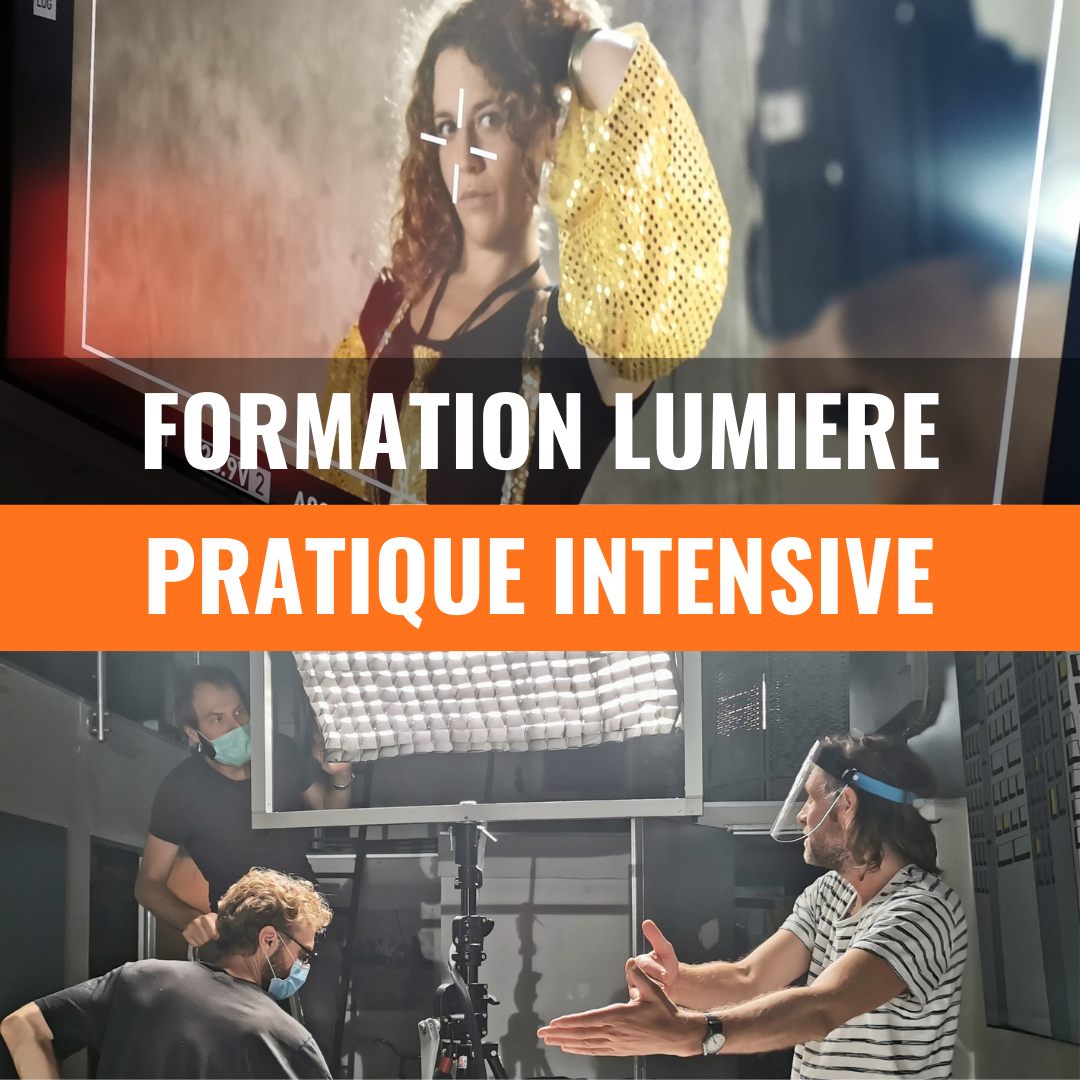

Catégorie: FormationsRepaire publié le 23 Oct 2024

Les vidéos

-

Publié parCanon France 7 Juin 2022

Publié parCanon France 7 Juin 2022 -

Publié parCanon France 17 Mai 2021

Publié parCanon France 17 Mai 2021 -

Publié parCanon France 5 Mars 2021

Publié parCanon France 5 Mars 2021

Vous souhaitez annoncer sur le Repaire ? Contactez-nous

-

-

Publié parLucas.janiszewski 19 Décembre 2025

Publié parLucas.janiszewski 19 Décembre 2025 -

Publié parLucas.janiszewski 18 Décembre 2025

Publié parLucas.janiszewski 18 Décembre 2025 -

Publié parLucas.janiszewski 18 Décembre 2025

Publié parLucas.janiszewski 18 Décembre 2025

-

-

-

Publié parMarina 29 Octobre 2025

Publié parMarina 29 Octobre 2025 -

Publié parmaximetrage 19 Septembre 2025

Publié parmaximetrage 19 Septembre 2025 -

Publié parMarina 30 Avril 2025

Publié parMarina 30 Avril 2025

-

-

-

Conseil achat camescope, pour filmer match de foot enfant

BarruWhite 7 Décembre 2025

-

Le P, A, S ou M en vidéo & retour sur le Nikon ZR

Lolive67 17 Décembre 2025

-

Correction super8 numérisé

RVQ35 4 Décembre 2025

Chargement... -

Conseil achat camescope, pour filmer match de foot enfant

-

-

- Réponses:

- 234

- Nb. vues:

- 5 435

-

- Réponses:

- 7

- Nb. vues:

- 202

-

- Réponses:

- 90

- Nb. vues:

- 1 870

Chargement... -

-

-

Upgrade config ... DVR

jazzyjez a répondu 3 Janvier 2026, à 07:38

-

Neat ou Topaz

colombin a répondu 3 Janvier 2026, à 07:22

-

Moniteur vidéo vertical

caraibe a répondu 3 Janvier 2026, à 01:41

Chargement... -

Upgrade config ... DVR

Dernières Occasions

Dernières Formations

-

Catégorie: FormationsRepaire publié le 23 Oct 2024